の続きです。

tapply関数でメーカー別の販売台数を見てみましょう。

トヨタが204,628台でダントツですね。2位がホンダの63,507台、3位が日産の62,943台です。

メーカーごとの平均順位はどうでしょうか?

トヨタが15.78で1位ですね。2位が日産で24.75、3位がホンダで27.17です。日産とホンダの販売台数を比較してみましょう。

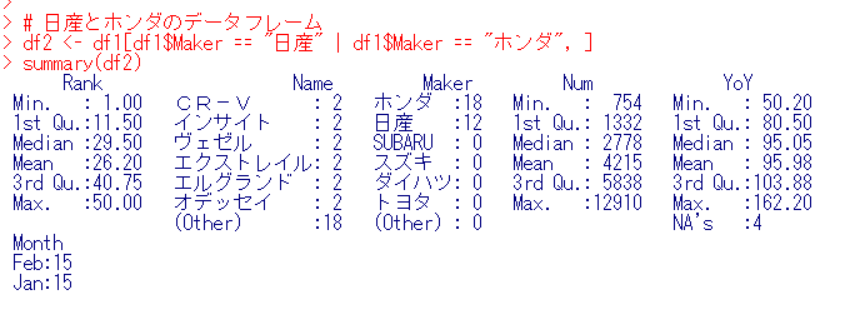

まず、日産とホンダだけのデータフレームを用意します。

Makerの列を見ると、ホンダが18、日産が12となっていますので、ホンダのほうがランクインしている会社が多いということですね。

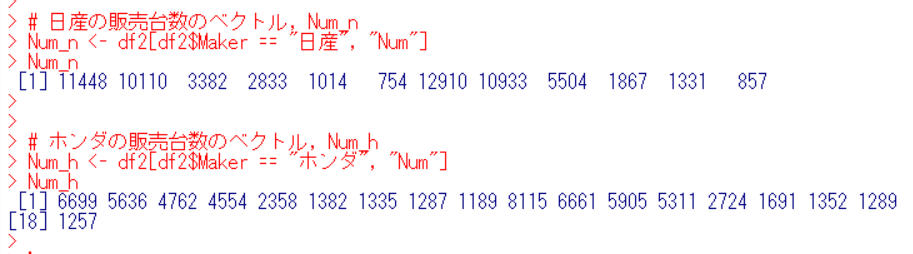

日産の販売台数のベクトル、ホンダの販売台数のベクトルを作ります。

それぞれの統計値を見てみます。

日産は平均値は5245台、平均値の95%信頼区間は2266台から8223台です。

ホンダはどうでしょうか?

ホンダは平均値は3528台、平均値の95%の信頼区間は2345台から4710台です。

両社の平均値に有意な違いは無さそうです。

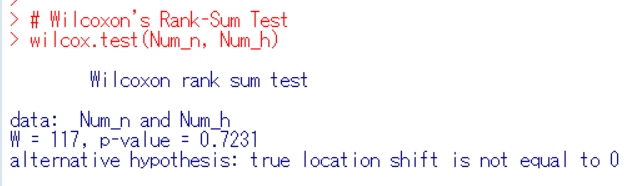

データの数が日産は12、ホンダは18と少ないので、Wilcoxon Rank-Sum Testで調べましょう。wilcox.test関数です。

p-value = 0.7321なので両社の販売台数の間に有意な違いはないようです。

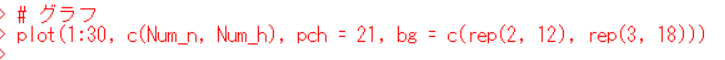

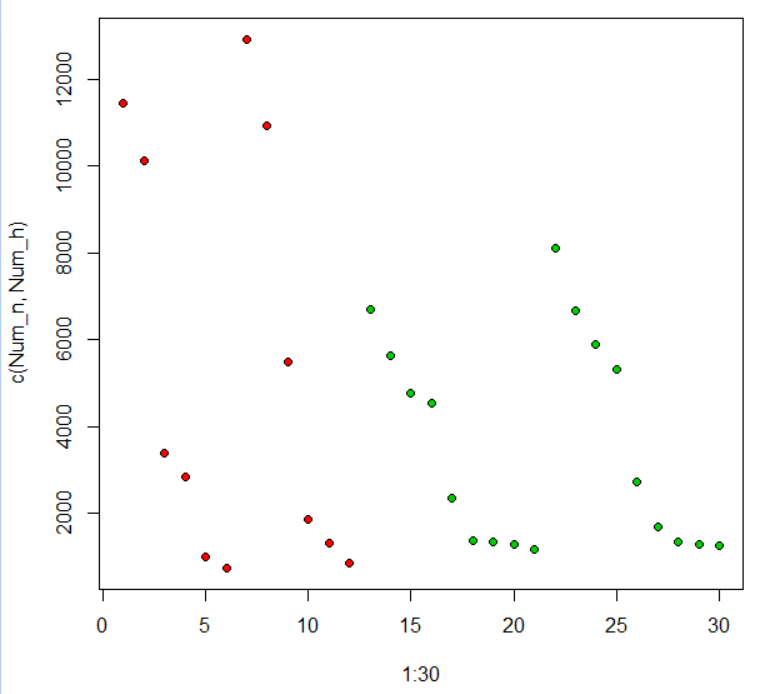

グラフで見てみます。

赤いのが日産、青いのがホンダです。日産は上位2種類のクルマが目立ちますね。

両社のランクについても同じようにしてみましょう。

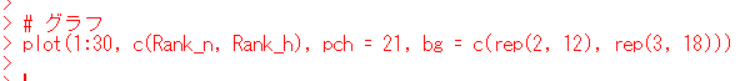

グラフにしてみます。

日産(赤い点)のほうが範囲が大きいですね。統計値を調べます。

日産の順位の平均値の95%信頼区間は12から37、ホンダは20から34ですので両社のあいだに有意な違いは無いですね。wilcox.testで確認します。

p-valueが0.8323なのでやはり両社に違いがあるとは言えないですね。

今回は以上です。